“Training Humans”. Nuove tecnologie, pregiudizi vecchi

Come “vedono” il mondo i computer? Lo racconta la mostra visitabile fino al 24 febbraio 2020 presso l’Osservatorio della Fondazione Prada a Milano

Venerdi, 04/10/2019 - Ultimamente si parla molto di intelligenza artificiale, ma forse ci si interroga ancora troppo poco su come le macchine vengano addestrate a interpretare il mondo. “Training Humans”, l’interessantissima mostra allestita fino al 24 febbraio 2020 negli spazi dell’Osservatorio della Fondazione Prada, al 5° piano della Galleria Vittorio Emanuele II, a Milano, ha invece il grande merito di illustrare i meccanismi di addestramento dell’intelligenza artificiale, meccanismi che appaiono scientifici e neutrali, ma che a volte nascondono invece posizioni ideologiche retrograde, razziste o sessiste.

Venerdi, 04/10/2019 - Ultimamente si parla molto di intelligenza artificiale, ma forse ci si interroga ancora troppo poco su come le macchine vengano addestrate a interpretare il mondo. “Training Humans”, l’interessantissima mostra allestita fino al 24 febbraio 2020 negli spazi dell’Osservatorio della Fondazione Prada, al 5° piano della Galleria Vittorio Emanuele II, a Milano, ha invece il grande merito di illustrare i meccanismi di addestramento dell’intelligenza artificiale, meccanismi che appaiono scientifici e neutrali, ma che a volte nascondono invece posizioni ideologiche retrograde, razziste o sessiste. Del resto sono ormai numerosi i segnali che dovrebbero metterci in guardia da un’eccessiva fiducia nella presunta “intelligenza” e imparzialità degli algoritmi. Basti pensare ai frequenti episodi di censura di opere d’arte sui social network, causati dall’incapacità degli algoritmi di distinguere tra nudi artistici e pornografia. Episodi che, fino a poco tempo fa, venivano semplicemente liquidati con sprezzante sarcasmo, ironizzando sull’ottocentesca pruderie delle macchine, ma che forse meriterebbero un approfondimento. Vittorio Sgarbi, peraltro, denuncia da tempo il fatto che Facebook ha ripetutamente bloccato post destinati alla promozione di alcune sue mostre (da ultimo i nudi di Antonio Canova esposti presso la Fondazione Canova di Possagno, presieduta dal critico stesso) e ha reagito con forza, contestando la violazione della libertà di espressione e manifestando l’intenzione di chiedere al social network un cospicuo risarcimento. In un’epoca in cui la comunicazione sui social è così importante, dover rinunciare a certe immagini nella promozione di un evento (Facebook ha censurato perfino Le tre Grazie di Canova) provoca infatti agli organizzatori un danno economico. Grande scalpore ha suscitato, recentemente, anche la censura di un nudo imponente, Modella su sfondo blu, dipinto nel 1910 da Natalia Goncharova (1881-1962). L’episodio è stato reso noto a fine agosto dalla Fondazione Palazzo Strozzi, che si è vista rifiutare da Instagram la pubblicazione del video promozionale della rassegna dedicata alla pittrice russa a causa di «immagini raffiguranti nudità e porzioni di pelle eccessive». Nel denunciare l’accaduto, Palazzo Strozzi, che a Firenze ospita la mostra (in corso fino al 12 gennaio 2020), ha stigmatizzato il fatto che Natalia Goncharova sia stata censurata oggi «come nel 1910 quando in Russia fu la prima donna a esporre dipinti di nudi femminili mostrando il suo spirito anticonformista. Fu accusata e processata per offesa alla pubblica morale e pornografia ma venne sempre assolta». Gli algoritmi sembrano dunque riportarci indietro nel tempo, riattualizzando una visione del mondo (e della donna), che credevamo ormai superata, almeno in Occidente. Naturalmente ancora più

preoccupanti sono quei casi in cui gli algoritmi sono utilizzati per selezionare il personale. Nelle piattaforme di food delivery, ad esempio, l’algoritmo sceglie i fattorini in base a disponibilità e velocità, finendo così per premiare chi è disposto a turni massacranti, in barba ai più elementari diritti dei lavoratori. E come hanno denunciato i rider, sono soprattutto le donne a farne le spese.

preoccupanti sono quei casi in cui gli algoritmi sono utilizzati per selezionare il personale. Nelle piattaforme di food delivery, ad esempio, l’algoritmo sceglie i fattorini in base a disponibilità e velocità, finendo così per premiare chi è disposto a turni massacranti, in barba ai più elementari diritti dei lavoratori. E come hanno denunciato i rider, sono soprattutto le donne a farne le spese. In seguito a episodi come questi si sta facendo lentamente strada la consapevolezza che, dietro all’apparente neutralità degli algoritmi, si può talvolta celare una mentalità retriva, sessista e schiavista. Ma la colpa non è ovviamente delle macchine, quanto di chi le programma.

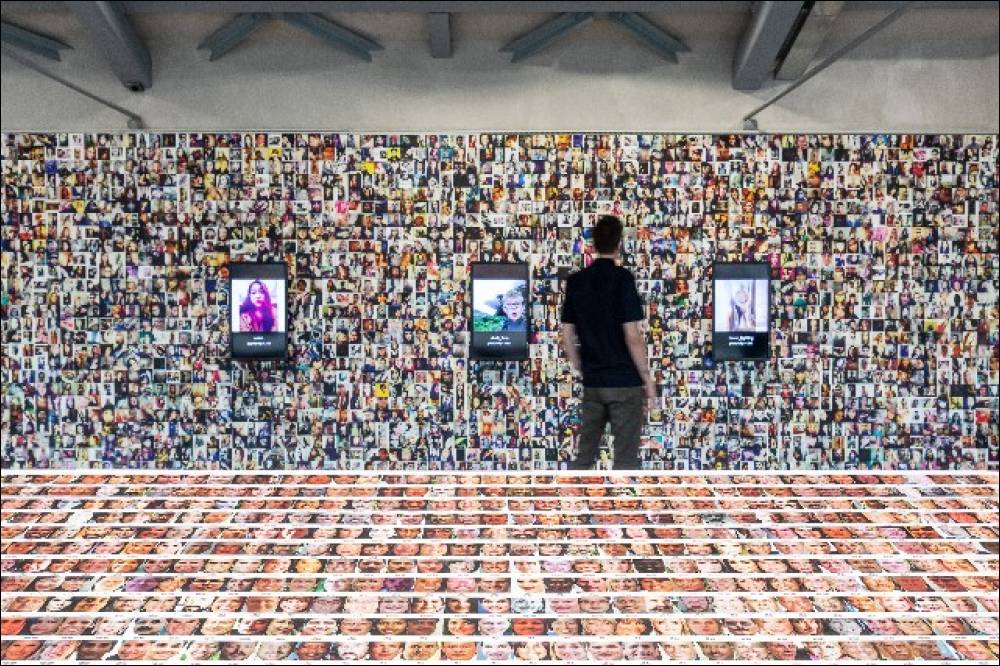

Ecco allora che si coglie meglio tutta l’importanza e la novità di una mostra come “Training Humans”, che solleva interrogativi inquietanti, svelando aspetti dell’educazione delle macchine ai quali pochi, finora, hanno prestato la giusta attenzione. I due curatori, Kate Crawford, professoressa e studiosa nell’ambito dell’intelligenza artificiale, e Trevor Paglen, artista e ricercatore, ci ricordano invece come le macchine siano addestrate da esseri umani. La mostra racconta l’evoluzione degli archivi di immagini utilizzati dagli anni Sessanta a oggi per insegnare ai sistemi di intelligenza artificiale a “vedere” il mondo. In particolare i curatori si sono concentrati sulle immagini utilizzate per il riconoscimento facciale computerizzato, un settore che per ovvie ragioni legate al tema della sicurezza è stato oggetto, negli Stati Uniti, di un costante interesse da parte della Cia fin dagli anni Sessanta. Queste raccolte di fotografie possono apparire neutre, ma analizzando le etichette che le accompagnano, ideate dai ricercatori per insegnare alle macchine a classificare i volti secondo l’età, il sesso, la razza, le espressioni facciali, eccetera, emerge con chiarezza come i dati di addestramento siano disseminati di pregiudizi e stereotipi. La razza, ad esempio, non dovrebbe essere un concetto superato? E riguardo al sesso il riconoscimento binario maschio/femmina non è antiquato? La complessità della vita emozionale, poi, si può davvero ridurre a una decina di stati d’animo? Inoltre, se inizialmente le fotografie utilizzate venivano scattate alle persone (con il loro consenso) appositamente per allenare le macchine, i curatori evidenziano come, dopo il 2000, con l’ascesa dei social media, i database di training si basino sempre più spesso su fotografie trovate in rete, impiegate in modo piratesco, senza chiedere alcun permesso agli interessati. La proliferazione di immagini disponibili on line, d’altro canto, ha portato negli ultimi dieci anni a una sempre maggiore efficacia del machine learning, cioè dell’apprendimento automatico dei computer. Ma nel tentativo di classificare gli esseri umani, dove finisce la presunta obiettività scientifica delle fotografie e delle categorie adottate e inizia la formulazione di un vero e proprio giudizio sulle persone ispirato a parametri ottocenteschi che ricordano le teorie di Cesare Lombroso? Il confine è molto labile e per questo la classificazione operata dagli algoritmi appare tanto obsoleta quanto pericolosa. La conclusione cui arrivano i curatori della mostra è che, lungi dall’essere neutra, «l’intelligenza artificiale è politica», dunque è essenziale che i cittadini siano consapevoli del modo in cui viene utilizzata e si interroghino su chi sta dietro agli algoritmi.

Alcune vedute della mostra (foto Marco Cappelletti, Courtesy Fondazione Prada).

©2019 - NoiDonne - Iscrizione ROC n.33421 del 23 /09/ 2019 - P.IVA 00878931005

Privacy Policy - Cookie Policy | Creazione Siti Internet WebDimension®

Privacy Policy - Cookie Policy | Creazione Siti Internet WebDimension®

Lascia un Commento